robots.txt su WordPress: come impostare il file

Non tutte le sottopagine o le directory del vostro sito web sono così importanti da dover essere necessariamente scansionate dai comuni motori di ricerca. Con l’aiuto del file robots.txt potete determinare quali sottopagine di WordPress devono essere prese in considerazione dal crawler e quali no. In questo modo, il vostro sito web si posiziona significativamente meglio nelle ricerche online. Qui vi spieghiamo cosa fa robots.txt su WordPress e come potete ottimizzare il file.

- Certificato SSL Wildcard incluso

- Registrazione di dominio sicura

- Indirizzo e-mail professionale da 2 GB

Cos’è robots.txt per WordPress?

I cosiddetti crawler cercano su Internet i siti web, 24 ore su 24. Questi bot sono inviati dai rispettivi motori di ricerca e catturano il maggior numero possibile di pagine e sottopagine (indicizzazione) per renderle disponibili per la ricerca. Affinché i crawler leggano bene il vostro sito web, hanno bisogno di essere guidati. In questo modo evitate che vengano indicizzati contenuti della vostra pagina irrilevanti per i motori di ricerca e vi assicurate che il crawler legga solo il contenuto che deve leggere.

È possibile usare robots.txt per questo controllo. Con WordPress e altri CMS, si usa questo file per determinare quali aree del vostro sito web sono rilevate dai crawler e quali no. Tramite il file robots.txt potete escludere o accettare i bot e fare inoltre distinzioni precise sulle voci da far trovare a determinati motori di ricerca e poi riprodurle nella ricerca. Poiché ogni dominio ha solo un budget di crawling limitato, è ancora più importante spingere le pagine principali e rimuovere le sottopagine insignificanti dal volume di ricerca.

Ottenete il vostro dominio dei sogni in pochi passaggi! Registrate comodamente il vostro dominio perfetto con IONOS e beneficiate di un servizio eccellente, numerose funzioni di sicurezza e una casella di posta elettronica da 2 GB.

A cosa serve robots.txt in WordPress?

In WordPress robots.txt specifica esattamente quali contenuti sono indicizzati e quali no, portando molti vantaggi. Per esempio, se essere ben posizionati in ogni ricerca è importante per la vostra pagina principale, ciò non vale per l’informativa sulla privacy della vostra pagina. Anche i commenti o gli archivi non forniscono alcun valore aggiunto nella ricerca e possono addirittura portare svantaggi, come quando i motori di ricerca riconoscono il contenuto duplicato e lo valutano negativamente. Con un file robots.txt in WordPress, potete assolutamente evitare che ciò accada e indirizzare invece i diversi crawler verso le aree del vostro sito web che dovrebbero essere realmente trovate.

Il file robots.txt automatico di WordPress

Per cominciare, WordPress stesso crea un file robots.txt e quindi fa un po’ di lavoro preliminare. Tuttavia, questo processo non è molto completo e deve quindi essere visto principalmente come un punto di partenza. Si presenta così:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/Lo “User agent” nella prima riga indica i crawler. “*” esprime che ogni motore di ricerca è autorizzato a inviare i propri bot alla vostra pagina. Questo passaggio è generalmente raccomandato, poiché così il vostro sito sarà più facile da trovare. Il comando “Disallow” blocca le seguenti directory per i crawler: in questo caso, l’amministrazione e la directory di tutti i file di WordPress. Robots.txt le blocca per i motori di ricerca, poiché i visitatori non hanno nulla da cercare sulle rispettive pagine. Per assicurarvi che siano accessibili solo a voi, proteggete queste aree con una password sicura.

Come amministratori, potete proteggere ulteriormente il vostro login WordPress tramite il file .htaccess.

Cos’è incluso in un file robots.txt in WordPress?

I motori di ricerca come Google devono naturalmente essere ancora in grado di trovare la vostra pagina senza complicazioni. Servizi piuttosto dannosi o dubbi come DuggMirror, tuttavia, non lo sono; verranno quindi esclusi da WordPress grazie a robots.txt. Per fare questo, dovete escludere dall’indicizzazione i temi, l’informativa sulla privacy e altre pagine che hanno poca o nessuna rilevanza. Anche i plugin non devono essere indicizzati, non solo perché non sono rilevanti per il pubblico, ma anche per ragioni di sicurezza. Se un plugin ha un problema di sicurezza, il vostro sito web può essere trovato e danneggiato.

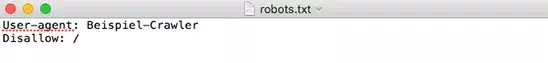

Nella maggior parte dei casi, i due comandi già menzionati sopra saranno sufficienti per fare un buon uso di robots.txt su WordPress: lo “User agent” indica a quali bot ci si deve rivolgere. In questo modo, potete determinare delle eccezioni per certi motori di ricerca o anche impostare delle regole di base. “Disallow” proibisce ai crawler di accedere a una pagina o sottopagina corrispondente. Il terzo comando “Allow” non è rilevante nella maggior parte dei casi, poiché l’accesso è consentito per impostazione predefinita. Questo comando vi serve solo se volete bloccare una pagina ma consentire l’accesso alla sua sottopagina.

La via più veloce per il vostro sito web: l’Hosting WordPress di IONOS stupisce con numerosi vantaggi. SSD, HTTP/2 e gzip sono inclusi, così come un dominio in omaggio per un anno. Scegliete il modello di tariffa che più vi si addice!

Modificare manualmente il file robots.txt su WordPress

Se volete apportare delle impostazioni individuali al file robots.txt su WordPress, è utile che siate voi stessi a eseguire queste modifiche. Per fare ciò, basteranno solo alcuni semplici passaggi.

Passaggio 1: per prima cosa, create in un qualsiasi editor di testo un file vuoto chiamato “robots.txt”.

Passaggio 2: successivamente, caricatelo nella directory principale del vostro dominio.

Passaggio 3: ora potete modificare il file via SFTP o caricare un nuovo file di testo.

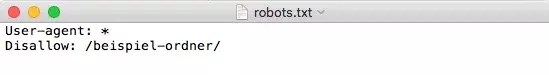

Grazie alle spiegazioni riportate sopra, gestite ora quali regole ed eccezioni si applicano al vostro sito web. Per bloccare l’accesso a una cartella specifica:

Plugin per la creazione di un file robots.txt per WordPress

Potete anche creare e cambiare il file robots.txt su WordPress con un plugin SEO. Ciò avviene in modo comodo e sicuro nella dashboard e può quindi diventare ancora più facile. Un plugin popolare per questo scopo è Yoast SEO.

Passaggio 1: per prima cosa dovete installare e attivare il plugin.

Passaggio 2: in secondo luogo, consentite al plugin di apportare modifiche avanzate. Per farlo, andate su “SEO” > “Bacheca” >, “Funzionalità” e fate clic su “On” sotto la voce “Avanzate” della relativa pagina da indicizzare.

Passaggio 3: dopo questa attivazione, fate le modifiche nella bacheca sotto “SEO” > “Strumenti” > “Modifica file”. A quel punto, potete creare e modificare direttamente un nuovo file robots.txt su WordPress. Le modifiche sono poi implementate direttamente.

Com’è possibile verificare le modifiche?

Avete impostato il vostro sito web, stabilito delle regole e, almeno in teoria, bloccato i crawler e reso invisibili le sottopagine. Ma come fate a sapere se tutte le vostre modifiche sono state effettivamente apportate? Nella Google Search Console avete a disposizione lo strumento “Tester dei file robots.txt”. Inserite lì le vostre pagine e sottopagine e poi verificate se possono essere trovate o se sono bloccate. La scritta in verde “accettato” in basso a destra indica che i crawler troveranno e considereranno la pagina, la scritta in rosso “bloccato” indica che la pagina non sarà indicizzata.

Conclusione: robots.txt ottimizza e protegge il vostro sito web

Il file robots.txt è un metodo semplice ed efficace in WordPress per determinare quali aree del vostro sito devono essere trovate e da chi. Se usate già un plugin SEO come Yoast, è più facile effettuare modifiche al robots.txt. Altrimenti, il file può anche essere creato e adattato manualmente senza problemi.

Nella Digital Guide di IONOS troverete preziosi consigli su WordPress. Vi aiutiamo a evitare gli errori più frequenti di WordPress, vi spieghiamo come rendere più veloce un sito WordPress e vi mostriamo cosa sia l’editor Gutenberg di WordPress. Qui troverai sicuramente le risposte che cerchi.