Cloaking: violare le direttive di Google per la SEO

Si parla di cloaking (termine inglese che significa “nascondere“) quando un server mostra a un motore di ricerca un altro contenuto rispetto a quello che un sito effettivamente ha. Il metodo black hat viene utilizzato come un espediente per migliorare il posizionamento di un sito web. Google e altri motori di ricerca considerano questo tipo di indicizzazione come una violazione delle linee guida dettate. Va però considerato che nel cloaking l’intento di manipolazione non è sempre l’obiettivo principale.

Le origini del cloaking

Siti web i cui contenuti consistono principalmente di grafiche, video o animazioni flash, ottengono di regola nelle SERP un cattivo posizionamento. Contenuti multimediali, apprezzati da molti utenti, possono essere letti dai motori di ricerca basati su testi solo in modo generico. Questo gap è però facilmente compensabile tramite il cloaking: invece della pagina originale viene mostrato al crawler una descrizione dell’immagine e del video e, quindi, viene mostrato un sito in mera forma testuale. I motori di ricerca possono elaborare facilmente questi contenuti e indicizzare di conseguenza l’offerta web. Tuttavia se un sito web presenta diverse versioni da far leggere ai crawler, è possibile che si tratti di un abuso.

Cloaking come escamotage

I gestori di siti web utilizzano sempre più metodi di cloaking per presentare ai motori di ricerca contenuti che i visitatori non possono vedere. Questo tipo di “manipolazione” potrebbe essere spiegato ricorrendo all’esempio di un casinò online fittizio:

Per aumentare la visibilità sul World Wide Web, un casinò online consegna al crawler determinati contenuti su giochi di società, e questo benché i visitatori possano utilizzare solo giochi d’azzardo a pagamento. Di conseguenza il motore di ricerca, ingannato dalle false keyword trovate, mostrerà erroneamente il sito tra i risultati di chi ricerca giochi di società. Questo non è ben visto dai visitatori e riduce l’usabilità del motore di ricerca.

Per evitare questi escamotage, i motori di ricerca reagiscono in modo molto duro al cloaking. Il leader dei motori di ricerca Google possiede per questi casi un team Webspam specializzato. I gestori di siti web che utilizzano metodi non riconosciuti, potrebbero fare i conti con la rimozione completa del loro sito dall’indice di ricerca.

Tecniche di cloaking

I gestori di siti web che ricorrono ai metodi black hat, utilizzano di regola due diverse tecniche per raggirare i motori di ricerca.

Agent Name Delivery

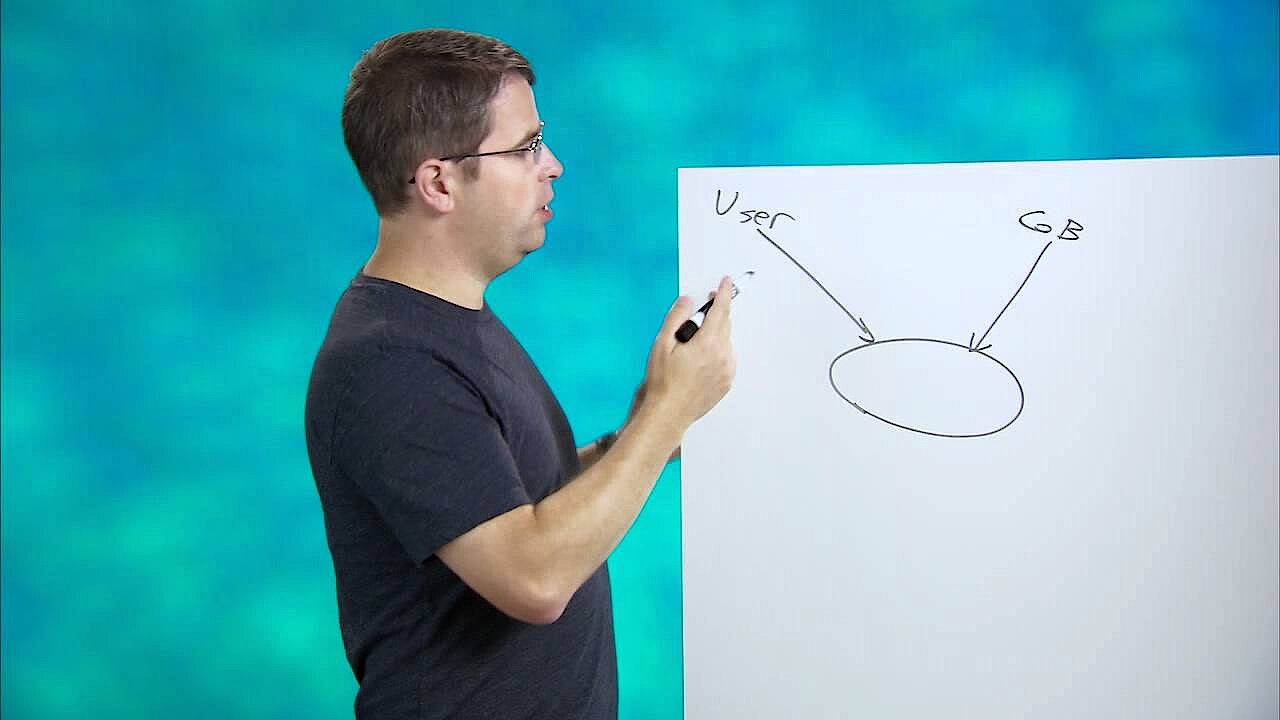

L’accesso a un sito web avviene di regola tramite un cosiddetto user agent. Esempi di user agent sono le applicazioni lato client come browser web o programmi automatizzati come crawler dei motori ricerca. È possibile riconoscerli tramite un identificativo specifico: l’agent name. Questo permette a un server di adattare al relativo browser i contenuti richiesti tramite fogli di stile ottimizzati e così di aumentare l’usabilità di un sito. Un agent name delivery crea pertanto la base per una visualizzazione ottimizzata per i dispositivi mobili. Un procedimento del genere diventa però cloaking solo quando un gestore di un sito web integra determinati meccanismi, che reagiscono in modo appropriato agli agent name di crawler più conosciuti come il Googlebot e forniscono loro contenuti separati. Per eludere l’agent name delivery, i motori di ricerca camuffano pertanto i loro crawler con i comuni browser.

IP-Delivery

Oltre all’agent name, l’indirizzo IP offre la possibilità di catalogare i gestori di siti web e di dotarli di contenuti particolari. Il procedimento viene utilizzato nell’ambito del geotargeting, per mostrare ai visitatori di siti web diverse versioni linguistiche od offerte regionali. L’IP delivery diventa cloaking se un gestore di un sito web offre contenuti personalizzati agli indirizzi IP standard di un crawler. Questo tipo di SEO black hat ha successo però solo se il relativo bot utilizza sempre lo stesso indirizzo IP. Per evitare questa manipolazione, la maggior parte dei motori di ricerca utilizza indirizzi IP alternati.

In un video ufficiale su questo tema Matt Cutts (l’allora capo del team Webspam di Google) spiega in modo piuttosto chiaro che il geotargeting basato su IP e l’adattamento dei contenuti di siti web agli user agent Mobile non vengono in alcun modo considerati cloaking, bensì misure volontarie ai fini di migliorare l’usabilità per l’utente. Di conseguenza per Google non ha alcuna importanza se un utente francese visualizzi altri contenuti a causa di versioni linguistiche particolari rispetto a un utente tedesco, purché i contenuti siano coerenti con quello che un crawler trova sul sito Internet.

Consigli per i gestori di siti web

Il leader di mercato Google dà due consigli essenziali ai gestori di siti che vorrebbero escludere il rischio di un effetto cloaking involontario:

- I contenuti di siti web dovrebbero essere realizzati in modo tale che gli utenti reali e i crawler visualizzino sempre gli stessi contenuti.

- Righe di codice che cercano esattamente l’agent name o l’indirizzo IP di un crawler, sono sospetti e andrebbero evitati.

Andrebbe inoltre evitata un’elaborazione basata sui motori di ricerca di contenuti difficili da analizzare per i craweler sotto forma di una versione web separata solo per i bot. Al contrario invece immagini, video o animazioni flash dovrebbero avere una descrizione nei relativi meta tag.

Su Google Search Console potete vedere come i bot di Google visualizzano il vostro sito.