Hyperscale computing: load balancing per grandi quantità di dati

Tutti parlano di big data e cloud computing. Parole chiave del momento sono anche Industria 4.0, Internet of Things o guida autonoma. Queste tecnologie richiedono l’interconnessione di un gran numero di sensori, dispositivi e macchine: ne risultano enormi quantità di dati, che devono essere elaborati in tempo reale e tradotti in loco in azioni estremamente rapide. Questa quantità di dati, che sia di tipo industriale o privato, nel campo scientifico o della ricerca, cresce con una rapidità esponenziale. Attualmente creiamo ca. 220.000 post su Instagram, 280.000 Tweet e 205 milioni di mail al minuto.

Non è sempre possibile prevedere quando saranno richieste ai server determinate capacità. Per poter reagire a queste richieste in costante evoluzione, le capacità dei server devono essere scalabili. La nostra guida sull’hyperscale computing vi svelerà quali strutture fisiche sono necessarie e come collegarle al meglio. Sulla base di queste informazioni potrete optare per soluzioni server che rispondano al meglio alle vostre esigenze.

- vCPU estremamente vantaggiose e potenti core dedicati

- Massima flessibilità senza periodo contrattuale minimo

- Servizio di assistenza tecnica 24 ore su 24, 7 giorni su 7

Cos’è l’hyperscale?

“Hyperscale” può essere tradotto in italiano come “scalabilità di dimensioni straordinarie”. Il termine è utilizzato nel mondo dell’informatica per una determinata struttura organizzativa dei server.

Hyperscale: descrive sistemi di cloud computing scalabili, che contano un gran numero di server, il cui numero, può essere aumentato o diminuito a seconda delle necessità collegati ad una rete. Una rete di questo tipo è in grado di elaborare molti accessi e mettere a disposizione capacità inferiori in caso di scarso utilizzo.

Scalabilità è il termine utilizzato per indicare che la rete si adatta a requisiti di prestazioni variabili. I server hyperscale sono piccoli e semplici sistemi orientati verso uno scopo ben definito; per raggiungere la scalabilità vengono collegati orizzontalmente tra di loro. Con il termine orizzontale si descrive la condizione per cui, al fine di aumentare la prestazione di un sistema IT, vengono aggiunte ulteriori capacità ai server; a livello internazionale si usa anche il termine scale-out.

La procedura opposta, quella della scalabilità verticale (scale-up) definisce l’ampliamento di un sistema locale preesistente, che viene dotato di un miglior hardware, quindi con una maggior memoria principale, una CPU più veloce, dischi fissi maggiormente performanti o schede grafiche più veloci. In pratica, prima della scalabilità orizzontale si implementa la tecnologia presente, fino a raggiungere i limiti tecnici o mantenendosi entro costi hardware accettabili. Dopodiché, diventa quasi sempre indispensabile passare all’hyperscaler.

Come funzione l’hyperscale?

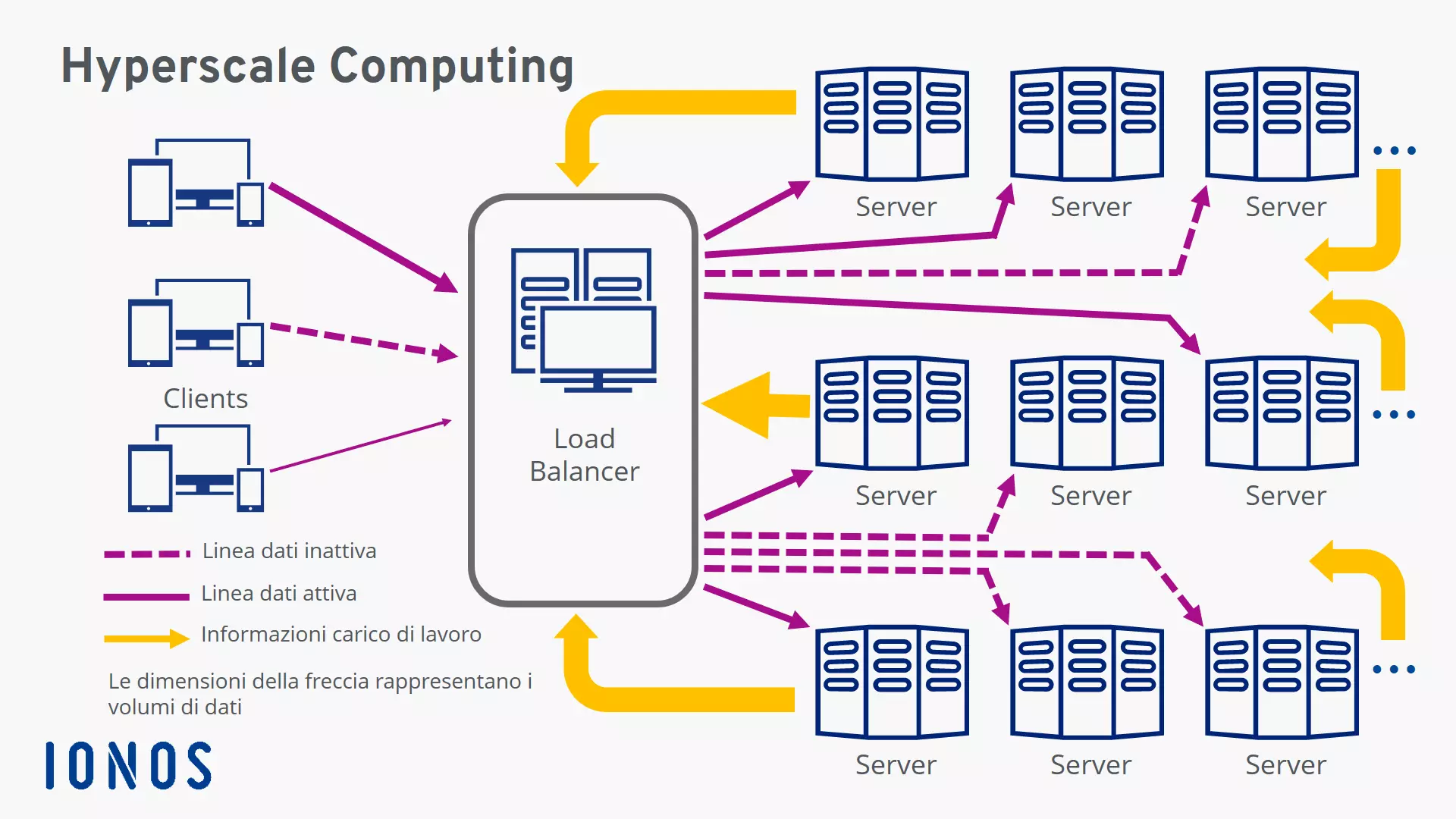

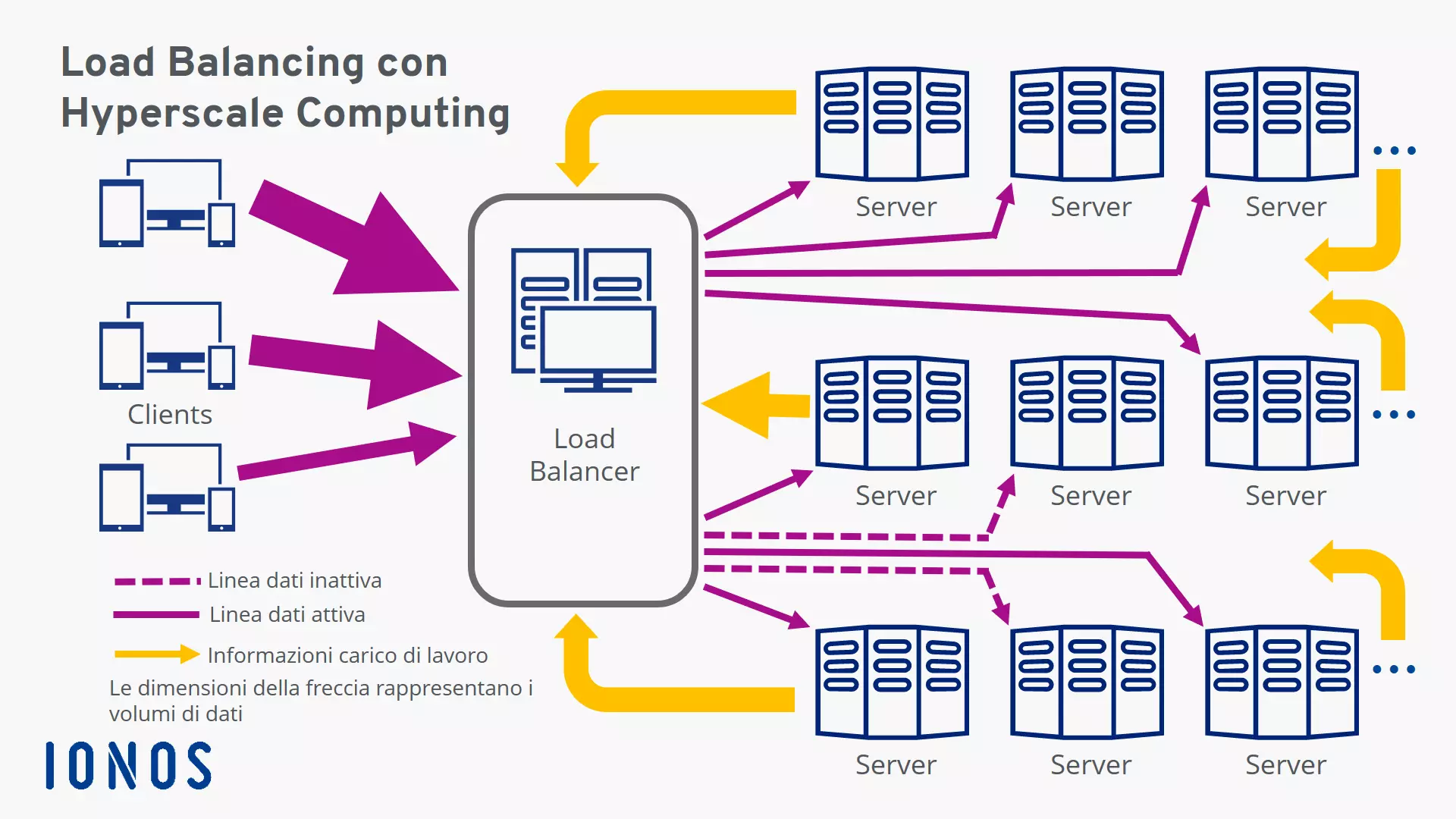

Nell’hyperscale computing vengono collegati orizzontalmente dei semplici server. In questo contesto con “semplici” non si intende “primitivi”, bensì “modulari”. Ci sono quindi poche e basilari convenzioni, per esempio protocolli di rete. In questo modo è facile gestire la comunicazione dei server tra di loro.

La “richiesta” dei server necessari in un dato momento viene inviata tramite un computer, il cosiddetto load balancer, che gestisce le richieste in ingresso e le distribuisce alle capacità libere. Nel farlo si controlla costantemente la misura in cui i server utilizzati sono impegnati con i volumi di dati da elaborare e, in caso di necessità, vengono collegati altri server, o se si registra un calo della richiesta questi vengono scollegati.

Diverse analisi hanno dimostrato che nelle aziende solo una quota che va dal 25 al 30 per cento dei dati presenti viene utilizzata in maniera attiva. Le banche dati inutilizzate includono per esempio copie di sicurezza, dati relativi ai clienti, dati di ripristino. Senza un chiaro sistema di classificazione, è difficile reperire questi dati in caso di necessità e i backup a volte richiedono giorni interi. Tutto ciò viene semplificato con l’hyperscale computing. L’intero hardware per il computing, per la memoria e le reti, presenta ancora solo un punto di contatto con il backup di dati, sistemi operativi e altri software richiesti. La combinazione di hardware e servizi di supporto consente di estendere l’ambiente computing necessario in un dato momento su varie migliaia di server.

Ciò limita l’eccessiva copiatura dei dati e semplifica l’applicazione di direttive e controlli di sicurezza all’interno delle aziende consentendo anche una riduzione dei costi relativi a personale e gestione.

Vantaggi e svantaggi dell’hyperscale computing

La possibilità descritta di ampliare o diminuire nuovamente le capacità del server con semplicità comporta sia vantaggi che svantaggi. Vediamoli insieme.

I vantaggi

- La scalabilità non è soggetta a limiti, le aziende restano ben preparate per i quantitativi di dati futuri, permettendo un adeguamento al mercato rapido ed economicamente vantaggioso.

- Le aziende devono disporre di strategie a lungo termine per lo sviluppo del proprio settore IT.

- I fornitori di hyperscale computing garantiscono un’elevata sicurezza in caso di malfunzionamento grazie a soluzioni ridondanti.

- Si evitano dipendenze grazie all’uso contemporaneo di più fornitori.

- Le spese calcolabili in modo trasparente e l’elevata efficienza dei costi costituiscono un sostegno ottimale per il raggiungimento degli obiettivi aziendali.

Gli svantaggi

- Vengono ceduti dei dati.

- Le capacità server e di archiviazione aggiuntive possono rappresentare anche nuove fonti di errore.

- Si richiede un maggior impegno alla gestione interna aziendale e responsabilità da parte dei dipendenti, a lungo termine però ciò rappresenta un vantaggio.

- Gli utenti dipendono dal regime tariffario del fornitore hyperscale.

- Ciascun fornitore ha la propria interfaccia utente.

Per poter ben confrontare pro e contro, le aziende possono scegliere una soluzione ibrida e spostare backup di grandi dimensioni e dati utilizzati raramente in cloud. In questo modo tali dati non occupano le capacità di salvataggio di un centro di elaborazione dati interno all’azienda. Un esempio è costituito dai dati personali di un utente di uno shop online, che, su richiesta dello stesso utente, devono essere resi o cancellati, oppure i dati aziendali con obbligo di conservazione.

Cos’è un hyperscaler?

Con hyperscaler si definisce il gestore di un centro di elaborazione dati che offre servizi scalabili di cloud computing. La prima azienda a entrare in questo mercato è stata Amazon nel 2006, con Amazon Web Services (AWS). Si tratta di un’affiliata che dovrebbe aiutare a sfruttare al meglio gli stessi centri di elaborazione dati di Amazon a livello mondiale. Nel frattempo AWS offre molti servizi specifici e la sua quota di mercato ammonta a circa il 40 per cento. Gli altri due protagonisti del settore sono Microsoft, con il suo servizio Azure (2010), e Google Cloud Platform (2010). Anche la società IBM è un importante fornitore di hyperscale computing. Queste possibilità tecniche vengono offerte tramite partner autorizzati anche per mezzo di centri di elaborazione dati in Italia, elemento importante per molte aziende, in modo particolare dall’entrata in vigore del nuovo regolamento generale sulla protezione dei dati.

Con IONOS Cloud, IONOS presenta un’alternativa ai grandi hyperscaler statunitensi, incentrata su Infrastructure as a Service (IaaS), con offerte come Compute Engine, Managed Kubernetes, S3 Object Storage o un Private Cloud.